KI im Vergleich

Hörgeräte sind längst nicht mehr nur Medizinprodukte – Akkus machen die Nutzung komfortabler, Bluetoothkonnektivität hievt das Hörsystem auf den Status eines Lifestyle-Produkts. Auch in der Audiologie hat sich einiges getan. Ein Begriff, der in letzter Zeit oft fällt: Künstliche Intelligenz. Aktuell spielen vor allem die Hersteller Oticon und Widex mit diesem Begriff. „KI“ klingt überwältigend, nach science-fiction – also: Buzzword oder richtungsweisend? Dieser Frage gehen wir in einer kleinen Artikelserie nach.

Künstliche Intelligenz wird in vielen Bereichen genutzt. Bei Hörgeräten findet sie aktuell vor allem dann Einsatz, wenn es um die automatische Situationserkennung geht – doch das benötigt viel Vorarbeit. Die Hörsysteme von Oticon und Widex profitieren von einem KI-basierten Trainingsverfahren, das lange vor der Entwicklung ihrer Chips beginnt.

Statisches Trainingsverfahren mit KI als Unterstützung

© Oticon

Oticon wirbt für die aktuelle Oticon Polaris-Plattform damit, 12 Millionen Klangwelten erkennen zu können. All diese zu analysieren und für den Chip so aufzubereiten, dass dieser zwischen Sprache und Störlärm unterscheiden kann, wäre manuell nicht zu bewältigen gewesen. Stattdessen lernte eine KI anhand festgelegter Parameter die Art der Signale kennen. Unter vereinzelten Stichproben durchlief der Polaris Chip die rund 12 Millionen Klangszenen automatisch. Irgendwann konnte er mit hoher Genauigkeit feststellen, wie Sprache, Verkehr oder Vogelgezwitscher klingen und die gewünschten Signale entsprechend verstärken. Künstliche Intelligenz wurde hier also verwendet, um den Trainingsprozess erheblich zu beschleunigen.

Oticon nutzt dazu ein Deep Neuronal Network (DNN), das von der Verarbeitungsweise des menschlichen Gehirns inspiriert ist. Sehr vereinfacht gesagt kategorisiert es die aufgenommenen Klänge und bewertet, welche Signale verstärkt werden müssen. Nur so ist das Hörsystem in der Lage, die antrainierten 12 Millionen Klangszenen 500 Mal pro Sekunde mit der vorherrschenden Hörsituation abzugleichen (Stichwort MoreSound Intelligence). Mit Fug und Recht kann Oticon also durchaus behaupten, im Prinzip für jede Situation die passende Klangeinstellung parat zu haben.

Dynamisches Training, oder: Die KI lernt im Alltag.

© Widex

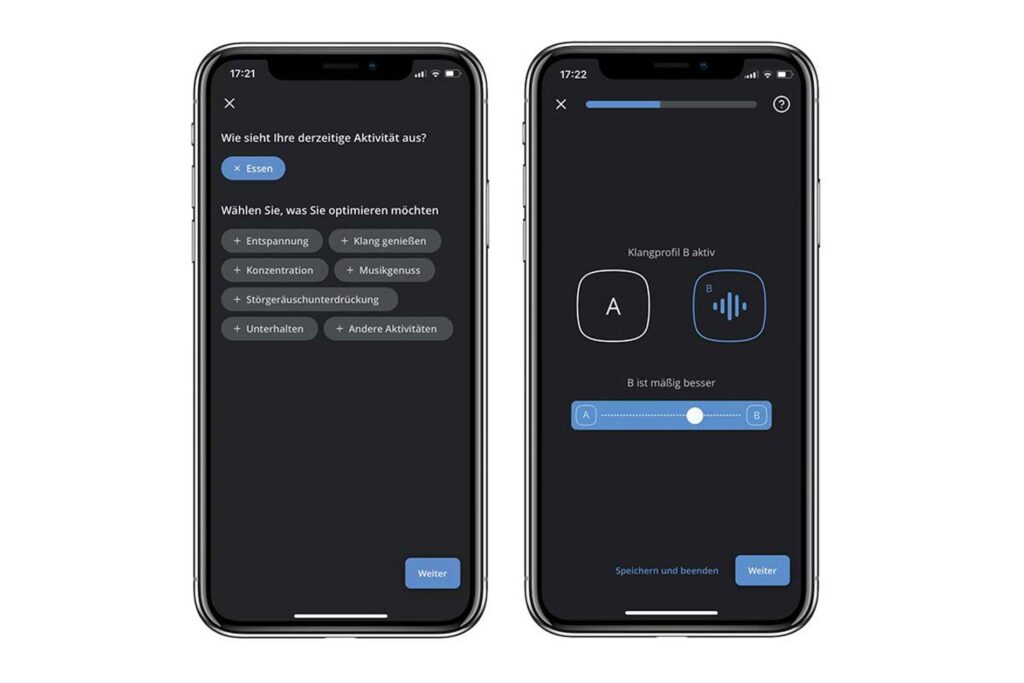

Auch die Moment-Hörsysteme von Widex wurden auf diese Weise trainiert, wenngleich es hier nicht ganz so viele Trainingsabläufe waren. Seit Ende 2018 verfolgt der Hersteller jedoch ohnehin einen anderen Ansatz: Durch die App-Funktion SoundSense Learn können Nutzer in schwierigen Klangsituationen selbst Abhilfe schaffen, indem sie eine Reihe vorgeschlagener Klangeinstellungen bewerten: Mithilfe von A/B-Vergleichen nähert man sich so lange dem gewünschten Ergebnis an, bis es erreicht ist. Das System lernt also durch die Entscheidungen des Nutzers seine Präferenzen im echten Leben kennen.

Mit der Zeit und durch vermehrte Nutzung konnte nicht nur die Anzahl der durchschnittlich benötigten A/B-Vergleiche von 20 auf 15 gesenkt werden. Die gesammelten Erkenntnisse ermöglichten auch eine Weiterentwicklung dieser Funktion: MySound lernt fortlaufend vom Nutzungsverhalten aller Widex Moment-Träger weltweit, die ihre individuellen Klangprofile in die Cloud übetragen. Deshalb wird die KI immer treffsicherer. Erfahrungsgemäß seien laut Hersteller mittlerweile bereits 79 Prozent der Nutzer so zufrieden mit einem der ersten Klangvorschläge, dass keine weiteren Vergleiche mehr nötig sind.

MySound und SoundSense Learn bringen aber noch einen weiteren, entscheidenden Vorteil mit: Manchmal möchte man in objektiv ähnlichen Situationen die Umwelt völlig unterschiedlich wahrnehmen. Wer im Café sitzt und sich mit einer Freundin unterhält hat eine andere Intention als derjenige, der dort mit dem Laptop sitzt und arbeitet. Ein vorab trainiertes Hörsystem kann das nicht unterscheiden. Durch vorauswählbare Präferenzen wie „Klang genießen“, „Konzentrieren“ oder „Musikhören“ in Kombination mit MySound sind Widex Moment-Nutzer sehr flexibel.

Künstliche Intelligenz – Eine Gefahr für die Hörakustik-Branche?

Angesichts der Tatsache, dass sich gerade bei künstlicher Intelligenz bis heute schon beeindruckend viel getan hat, ist eine Frage durchaus berechtigt: Könnte in naher Zukunft künstliche Intelligenz nicht den Beruf des Hörakustikers obsolet machen?

Auf technischer Ebene vielleicht, aber es gehört ja noch viel mehr dazu. Simon Müller, Leiter Audiologie bei Widex, bringt es auf den Punkt: „KI wird auch in Zukunft nicht das leisten können, was HörakustikerInnen leisten: Mit Intuition auf emotionale Signale der Kunden während der Anpassung reagieren.“ Die Aufgabe des Hörakustikers ist schließlich auch, auf die Sorgen und Wünsche einzugehen, die während der Gespräche bei Terminen aufkommen.

Künstliche Intelligenz ist für die audiologische Weiterentwicklung von Hörgeräten essenziell. Durch sie kann man die Wiedergabe der Realität sehr viel granularer und bedürfnisorientierter gestalten. Der Unterschied liegt aktuell darin, auf welche Bedürfnisse der Fokus gelegt wird und wann die KI eingesetzt wird: Fortwährend oder als abgeschlossenes Training.

Im nächsten Teil: MySound und SoundSense Learn – Die KI hinter Widex